- Afhalen na 1 uur in een winkel met voorraad

- Gratis thuislevering in België vanaf € 30

- Ruim aanbod met 7 miljoen producten

- Afhalen na 1 uur in een winkel met voorraad

- Gratis thuislevering in België vanaf € 30

- Ruim aanbod met 7 miljoen producten

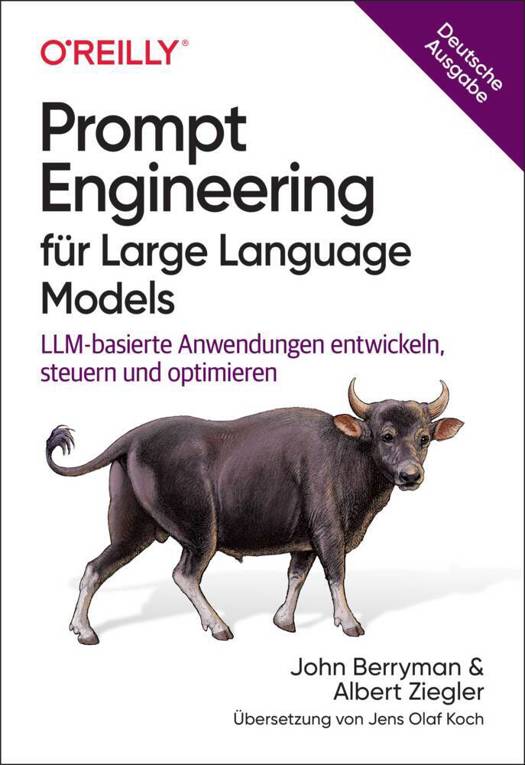

Prompt Engineering für Large Language Models

LLM-basierte Anwendungen entwickeln, steuern und optimieren

John Berryman, Albert ZieglerOmschrijving

- LLMs als leistungsstarke Bausteine für Anwendungen nutzen

- Den richtigen Prompt und Kontext für nützliche Ergebnisse gestalten

- Von der Erfahrung der GitHub-Copilot-Entwickler profitieren

- Fortgeschrittene Konzepte wie Conversational Agency und Workflow-Steuerung meistern

LLMs übernehmen in modernen Anwendungen die Rolle einer intelligenten Transformationsschicht. Sie verarbeiten komplexe Nutzeranfragen und generieren adaptive Antworten - oft innerhalb einer mehrstufigen Anwendungsschleife -, bevor dem Nutzer ein optimiertes Ergebnis präsentiert wird. Für Entwickler bedeutet das neue Anforderungen: LLMs gezielt zu steuern, ihren Output schrittweise zu verfeinern und ihre vielseitigen Einsatzmöglichkeiten in den Entwicklungsprozess zu integrieren.

Die Autoren, beide maßgeblich an der Entwicklung von GitHub Copilot beteiligt, vermitteln das komplette Spektrum des Prompt Engineerings - von den Grundlagen bis hin zu fortgeschrittenen Techniken wie Conversational Agency, der Integration externer Tools, der Orchestrierung komplexer Workflows und der Evaluierung von LLM-Anwendungen.

Effektives Prompt Engineering erfordert ein tiefes Verständnis dafür, wie sich Kontext optimal strukturieren und LLM-basierte Workflows effizient gestalten lassen, um nützliche Ergebnisse zu erhalten. Dieses Buch bietet eine praxisnahe Anleitung, um LLMs als leistungsfähige Bausteine produktiver Softwarelösungen einzusetzen.

Specificaties

Betrokkenen

- Auteur(s):

- Vertaler(s):

- Uitgeverij:

Inhoud

- Aantal bladzijden:

- 272

- Taal:

- Duits

- Reeks:

Eigenschappen

- Productcode (EAN):

- 9783960092704

- Verschijningsdatum:

- 15/07/2025

- Uitvoering:

- Paperback

- Afmetingen:

- 165 mm x 240 mm

Alleen bij Standaard Boekhandel

Beoordelingen

We publiceren alleen reviews die voldoen aan de voorwaarden voor reviews. Bekijk onze voorwaarden voor reviews.