- Afhalen na 1 uur in een winkel met voorraad

- Gratis thuislevering in België vanaf € 30

- Ruim aanbod met 7 miljoen producten

- Afhalen na 1 uur in een winkel met voorraad

- Gratis thuislevering in België vanaf € 30

- Ruim aanbod met 7 miljoen producten

Zoeken

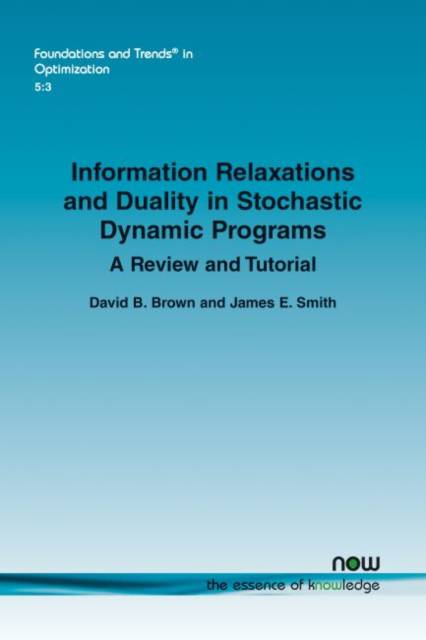

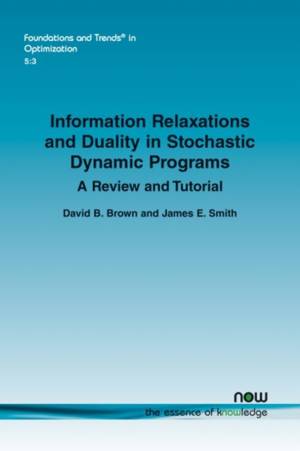

Information Relaxations and Duality in Stochastic Dynamic Programs

A Review and Tutorial

David B Brown, James E Smith

€ 79,95

+ 159 punten

Omschrijving

Dynamic Programming (DP) provides a powerful framework for modeling complex decision problems where uncertainty is resolved and decisions are made over time. But it is difficult to scale to complex problems. Monte Carlo simulation methods, however, typically scale well, but typically do not provide a good way to identify an optimal policy or provide a performance bound. To address these restrictions, the authors review the information relaxation approach which works by reducing a complex stochastic DP to a series of scenario-specific deterministic optimization problems solved within a Monte Carlo simulation. Written in a tutorial style, the authors summarize the key ideas of information relaxation methods for stochastic DPs and demonstrate their use in several examples. They provide a "one-stop-shop" for researchers seeking to learn the key ideas and tools for using information relaxation methods. This book provides the reader with a comprehensive overview of a powerful technique for use by students, researchers and practitioners.

Specificaties

Betrokkenen

- Auteur(s):

- Uitgeverij:

Inhoud

- Aantal bladzijden:

- 108

- Taal:

- Engels

- Reeks:

Eigenschappen

- Productcode (EAN):

- 9781680839623

- Verschijningsdatum:

- 21/03/2022

- Uitvoering:

- Paperback

- Formaat:

- Trade paperback (VS)

- Afmetingen:

- 156 mm x 234 mm

- Gewicht:

- 163 g

Alleen bij Standaard Boekhandel

+ 159 punten op je klantenkaart van Standaard Boekhandel

Beoordelingen

We publiceren alleen reviews die voldoen aan de voorwaarden voor reviews. Bekijk onze voorwaarden voor reviews.